¿Por qué la mayoría de los asistentes virtuales que utilizan la inteligencia artificial, como Siri de Apple y Alexa de Amazon, tienen nombres femeninos, voces femeninas y, a menudo, un estilo sumiso o incluso coqueto?

El problema se debe a la falta de diversidad dentro de la industria que está reforzando los estereotipos de género problemáticos.

Reporte afirma Alexa y Siri refuerzan estereotipos de género

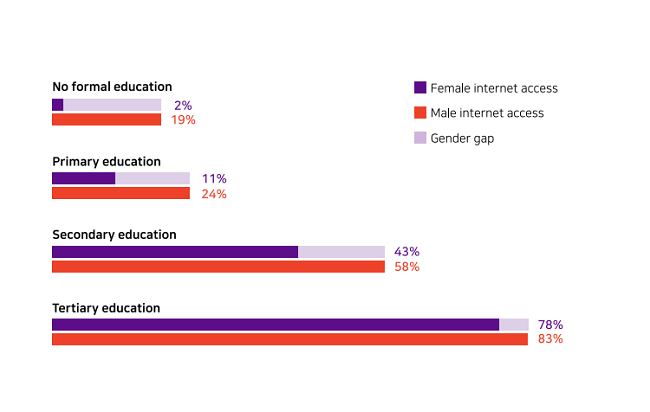

Ayudar a mujeres y niñas a desarrollar habilidades digitales se traduce en mujeres más fuertes, familias más fuertes, comunidades más fuertes, economías más fuertes y mejor tecnología.

Equipar a las mujeres y las niñas con habilidades digitales ayuda a ponerlas en pie de igualdad con los hombres con conocimientos digitales, y abre innumerables oportunidades para aumentar el poder.

Los sitios web y las aplicaciones móviles sobre salud y derechos legales, por ejemplo, pueden ayudar a las mujeres a tomar decisiones informadas para protegerse y cuidar de sí mismas y sus familias, mientras que las redes sociales y las comunicaciones digitales les permiten difundir información y compartir conocimientos más allá de su comunidad.

¿Por qué son los asistentes de voz principalmente femeninos?

Alexa, Cortana, Google Assistant y Siri son representantes bien conocidos de las compañías que los crearon y, posiblemente, tan reconocibles como parte de la imagen de una empresa como su CEO o fundador.

Los asistentes de voz se presentan regularmente en los anuncios, incluidos los comerciales de televisión que se reproducen durante eventos deportivos y premios que atraen la atención internacional.

Para justificar la decisión de convertir a las mujeres en asistentes de voz, compañías como Amazon y Apple han citado trabajos académicos que demuestran que las personas prefieren una voz femenina a la voz masculina.

Este razonamiento elimina las cuestiones de sesgo de género: las empresas obtienen ganancias al atraer y complacer a los clientes; los clientes quieren que sus asistentes digitales suenen como mujeres; por lo tanto, los asistentes digitales pueden obtener el mayor beneficio al sonar femenino.

“Las máquinas obedientes y complacientes que pretenden ser mujeres están ingresando a nuestros hogares, automóviles y oficinas”, dijo Saniye Gülser Corat, directora de la Unesco sobre la igualdad de género.

El mundo necesita prestar mucha más atención a cómo, cuándo y si las tecnologías tienen género y, lo que es más importante, quién las está generando.

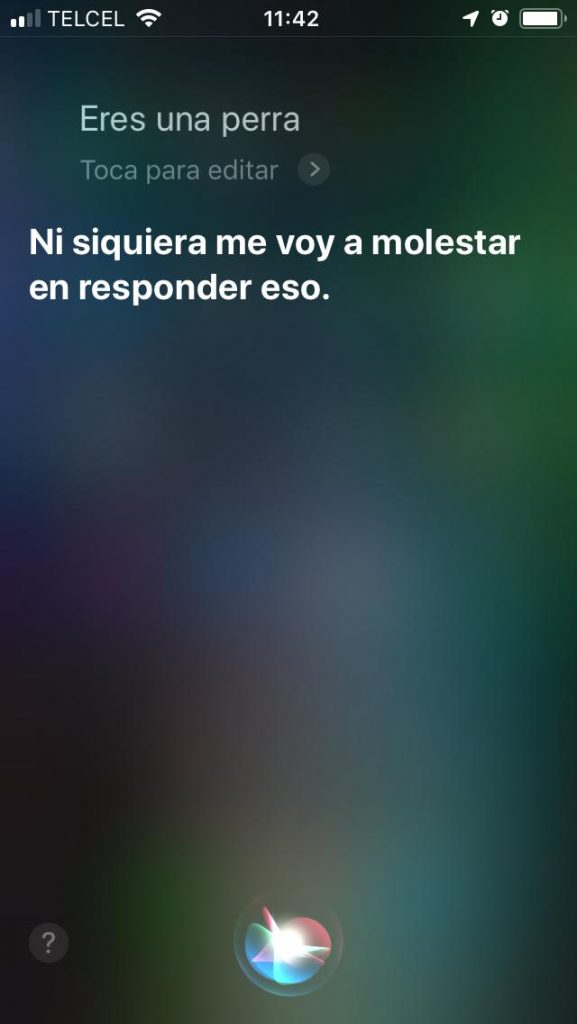

Una reflexión particularmente preocupante de esto es la “respuesta desviada, mediocre o apologética” que estos asistentes dan a los insultos.

Hallazgos del reporte que afirma Alexa y Siri refuerzan estereotipos de género

El informe toma prestado su título I’d Blush If I Could (“Sonrojaría si pudiera”) de una respuesta estándar de Siri, el asistente de voz de Apple, cuando el usuario lanzó un arrebato de género.

Cuando un usuario le dice a Alexa: You’re hot! (“Eres sexy”), su respuesta típica ha sido: “¡Qué amable!”

Si un usuario le decía, Hey Siri, you’re a bi…*. (“Oye, Siri, eres una perra.”) respondía algo similar.

La respuesta de Siri se modificó recientemente a “No sé cómo responder a eso”, pero el informe sugiere que la tecnología sigue teniendo un sesgo de género, argumentando que el problema comienza con los equipos de ingeniería que cuentan con personal abrumadoramente integrado por hombres.

Pero el abuso de género permanece sin cambios desde el lanzamiento de la tecnología en 2011.

Las asistentes de voz proyectadas como mujeres jóvenes proporcionan una poderosa ilustración de los sesgos de género codificados en productos tecnológicos, generalizados en el sector tecnológico y aparente en la educación en habilidades digitales.

El objetivo del reporte es exponer algunos de estos sesgos y presentar ideas para comenzar a cerrar la brecha de género en habilidades digitales que, en la mayor parte del mundo, es amplia y creciente.

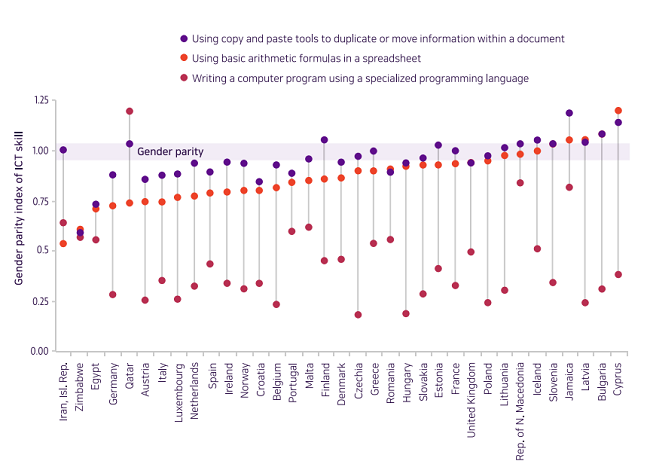

Hoy en día, las mujeres y las niñas tienen un 25% menos de probabilidades que los hombres de saber cómo aprovechar la tecnología digital para fines básicos, 4 veces menos de saber cómo programar computadoras y 13 veces menos probabilidades de solicitar una patente tecnológica.

En un momento en que cada sector se está convirtiendo en un sector de tecnología, estas brechas deberían hacer que los responsables de las políticas, los educadores y los ciudadanos actúen.

La investigación explica el papel que puede desempeñar la educación sensible al género para ayudar a restablecer las perspectivas de género de la tecnología y garantizar la igualdad para mujeres y niñas.

Alexa de Amazon, llamada así por la antigua biblioteca de Alejandría, es inequívocamente femenina.

Cortana de Microsoft fue nombrada por un personaje de la franquicia de videojuegos Halo que se proyecta a sí misma como una mujer sensual y desnuda.

Siri de Apple es un nombre nórdico que significa “mujer hermosa que te lleva a la victoria”.

El sistema Google Assistant, también conocido como Google Home, tiene un nombre neutral en cuanto al género, pero la voz predeterminada es femenina.

Este informe pone un sello en la sociedad a medida que se vuelven comunes en los hogares de todo el mundo y pueden influir en las interacciones con mujeres reales.

Cuanto más la cultura enseña a las personas a equiparar a las mujeres con las ayudantes, más se considerará a las mujeres reales como asistentes, y se las penalizará por no ser como asistentes.

Apple y Google declinaron comentar sobre el reporte. Amazon no respondió de inmediato a las solicitudes de comentarios. Eso solo afirma los hallazgos del informe.

El reporte, primero en ofrecer recomendaciones de las Naciones Unidas con respecto al género de tecnologías de inteligencia artificial insta a las empresas de tecnología y los gobiernos a que dejen de convertir a los asistentes digitales en mujeres por defecto y exploren el desarrollo de un asistente de voz neutral al género, entre otras orientaciones.

Los sistemas son un reflejo de disparidades de género más amplias dentro de la tecnología y la inteligencia artificial. Unesco señaló en el informe, publicado junto con el gobierno de Alemania y la Coalición de Igualdad de Habilidades, que promueve el equilibrio de género en el sector de la tecnología.

Las mujeres están muy poco representadas en la inteligencia artificial, lo que representa el 12 por ciento de los ingresos de los investigadores de IA y el 6 por ciento de los desarrolladores de software en el campo.

El informe señaló que las compañías de tecnología justifican el uso de voces femeninas señalando estudios que muestran que los consumidores prefieren las voces femeninas a las masculinas.

Pero otra investigación muestra que a la gente le gusta el sonido de una voz masculina cuando está haciendo declaraciones autorizadas, pero una voz femenina cuando está siendo “útil”, perpetuando aún más los estereotipos.

Los expertos dicen que el sesgo en IA y las disparidades más amplias dentro del campo de la programación no son nuevas: apuntan a una herramienta de contratación sexualmente inadvertida desarrollada por Amazon y la tecnología de reconocimiento facial que identifica erróneamente las caras negras como ejemplos.

“No siempre es un sesgo malicioso, es un sesgo inconsciente y la falta de conciencia de que existe este sesgo inconsciente, por lo que es perpetúa”, dijo Allison Gardner, cofundadora de Women Leading in A.I.

“Pero estos errores ocurren porque no hay equipos diversos y la diversidad de pensamiento e innovación para detectar los problemas obvios”.

Pero el informe ofrece orientación para la educación y pasos para abordar los problemas, que los defensores de la igualdad han impulsado durante mucho tiempo.

La organización de Gardner trabaja para traer a las mujeres que trabajan en IA junto con líderes empresariales y políticos para discutir la ética, el sesgo y el potencial de los marcos legislativos para desarrollar la industria de una manera que sea más representativa.

El grupo ha publicado su propia lista de recomendaciones para crear inteligencia artificial inclusiva, entre ellas el establecimiento de un organismo regulador para auditar algoritmos, investigar las quejas y garantizar que se tome en cuenta el sesgo en el desarrollo de nuevas tecnologías.

“Necesitamos cambiar las cosas ahora, porque estas cosas se están implementando ahora”, dijo Gardner, señalando la rápida propagación de los asistentes virtuales con el poder de IA.

“Estamos escribiendo los estándares ahora que se utilizarán en el futuro”.

Gardner dijo que también se necesitan cambios en la educación, porque el sesgo fue un síntoma de una representación insuficiente sistémica en un campo dominado por los hombres.

“Toda la estructura del área temática de la informática ha sido diseñada para ser centrada en los hombres, hasta la semántica que utilizamos”, agregó.

Aunque las mujeres ahora tienen más oportunidades en ciencias de la computación, más están desapareciendo del campo a medida que avanzan en sus carreras, una tendencia conocida como el fenómeno del “oleoducto permeable”.

¿Cuál es tu opinión acerca de los estereotipos de género y cómo los asistentes de voz los están esforzando?