La fabricación de coches autónomos están diseñados para facilitar el traslado y la movilidad de los usuarios, sin embargo, se han suscitado accidentes que ponen en duda si éstos son una buena opción tanto para los que usan el automóvil autónomo como los que se encuentran alrededor de él, como los peatones y otros coches.

Recordemos que hace unos meses hubo un accidente en Tempe Arizona, donde una mujer fue arrollada por un vehículo autónomo y falleció.

Por ello es que se discute la circulación de este tipo de coches, puesto que conducirlo no es nada más “mapear” el entorno y seguir las normas de circulación: es tomar decisiones complejas en cuestión de segundo.

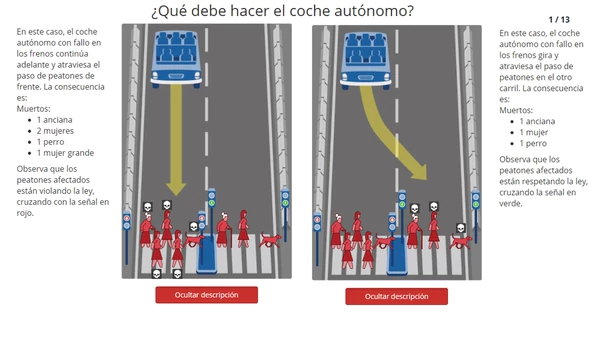

De acuerdo con el sitio de We Forum, un grupo de investigadores del MIT Media Lab crearon ‘Moral Machine’, un juego de ética que planteaba a los participantes el tipo de cuestiones éticas que, dentro de poco, tendrán que resolver los vehículos sin conductor.

El código moral de ‘Moral Machine’

Desde el lanzamiento de ‘Moral Machine’ en 2016, más de cuatro millones de personas participaron en el test y respondieron cosas como:

- ¿Qué vida debe proteger un coche autónomo la de sus ocupantes, la de los peatones, la de otros ocupantes?

- ¿De qué depende esa elección?

- ¿De la edad, del género, del número, de la especie de los implicados?

Se trata del estudio de ética global más grande que se ha realizado. A pesar de lo completo que es, todavía no está terminado. Se preveé que a finales del 2018 se publiquen los resultados.

La disyuntiva entre atropellar a una persona cruzando la carretera legalmente y atropellar a dos personas que la están cruzando de forma ilegal, las respuestas se dividen al 50%.

De acuerdo con el 40% de los participantes, daba igual a quién hubiera que matar. Lo principal era preservar la vida.

Alrededor del tema, existen dos grandes posturas fundamentales:

La de Derek Parfit que piensa que, aunque todas las tradiciones morales parecen distintas, en realidad son como escaladores subiendo la misma montaña por diferentes rutas. Es decir, hay diversidad de valores y normas morales, pero todas acaban convergiendo en la cima.

Por otro lado, está la opinión de Alasdair MacIntyre quien defende que aún no hemos llegado a un consenso moral sobre qué es bueno y qué es malo porque nuestros valores son incompatibles entre sí.

“Son tradiciones sociales y comunitarias enfrentadas (y esto es crucial) en su aplicación de la racionalidad práctica. Es decir, no seremos capaces de encontrar un consenso general para cada problema ético con el que nos encontremos”.

“La mayoría de las personas quieren vivir en un mundo en el que los vehículos minimicen el número de víctimas. Pero todos quieren que su automóvil los proteja a ellos primero a toda costa. Pero si todo el mundo actuase igual, los autos autónomos no reducirían las consecuencias de un accidente y todo acabaría siendo una tragedia”. La conclusión del informe del MIT es ambigua: “De momento parece no existir una manera sencilla de diseñar un algoritmo que concilie los valores morales con el interés propio”.